第二个版本:

upstream 实现负载均衡

upstream lb {

server 172.28.66.194:8082 max_fails=3 fail_timeout=30s; #max_fails=3 允许失败的次数,默认是1

server 172.28.66.194:8081 max_fails=3 fail_timeout=30s; #fail_timeout=30s 当请求失败后,暂停请求30s

}

server {

listen 8068;

client_max_body_size 100m;

server_name localhost;

access_log /usr/local/nginx/logs/8068-access.log main;

error_log /usr/local/nginx/logs/8068-error.log;

location / {

#proxy_pass http://172.28.66.194:8082;

proxy_pass http://lb;

proxy_redirect off ;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header REMOTE-HOST $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_connect_timeout 300; #跟后端服务器连接超时时间,发起握手等候响应时间

proxy_send_timeout 300; #后端服务器回传时间,就是在规定时间内后端服务器必须传完所有数据

proxy_read_timeout 600; #连接成功后等待后端服务器的响应时间,已经进入后端的排队之中等候处理

proxy_buffer_size 256k; #代理请求缓冲区,会保存用户的头信息以供nginx进行处理

proxy_buffers 4 256k; #同上,告诉nginx保存单个用几个buffer最大用多少空间

proxy_busy_buffers_size 256k; #如果系统很忙时候可以申请最大的proxy_buffers

proxy_temp_file_write_size 256k; #proxy缓存临时文件的大小

proxy_next_upstream error timeout invalid_header http_500 http_503 http_404;

proxy_max_temp_file_size 128m;

}

}upstream 支持的五种轮询算法:

1、轮询(默认)

每个请求按时间顺序逐一分配到不同的后端服务器,如果后端服务器down掉,能自动剔除。

2、ip_hash

在负载均衡系统中,假如用户在某台服务器上登录了,那么该用户第二次请求的时候,因为我们是负载均衡系统,每次请求都会重新定位到服务器集群中的某一个,那么已经登录某一个服务器的用户再重新定位到另一个服务器,其登录信息将会丢失,这样显然是不妥的。

我们可以采用ip_hash指令解决这个问题,如果客户已经访问了某个服务器,当用户再次访问时,会将该请求通过哈希算法,自动定位到该服务器。

每个请求按访问ip的hash结果分配,这样每个访客固定访问一个后端服务器,可以解决session的问题。

3、权重

weight=1 数字越大 负载越重

4、fair (第三方)

按后端服务器的响应时间来分配请求,响应时间短的优先分配。

upstream backend {

server server1;

server server2;

fair;

}

5、url_hash (第三方)

按访问url的hash结果来分配请求,使每个url定向到同一个后端服务器,后端服务器为缓存时比较有效。

例:在upstream中加入hash语句,server语句中不能写入weight等其他的参数,hash_method是使用的hash算法

upstream backend {

server squid1:3128;

server squid2:3128;

hash $request_uri;

hash_method crc32;

}

tips:

upstream bakend{#定义负载均衡设备的Ip及设备状态

ip_hash;

server 127.0.0.1:9090 down;

server 127.0.0.1:8080 weight=2;

server 127.0.0.1:6060;

server 127.0.0.1:7070 backup;

}

在需要使用负载均衡的server中增加

proxy_pass http://bakend/;

每个设备的状态设置为:

1.down 表示单前的server暂时不参与负载

2.weight 默认为1.weight越大,负载的权重就越大。

3.max_fails :允许请求失败的次数默认为1.当超过最大次数时,返回proxy_next_upstream 模块定义的错误

4.fail_timeout:max_fails次失败后,暂停的时间。

5.backup: 其它所有的非backup机器down或者忙的时候,请求backup机器。所以这台机器压力会最轻。

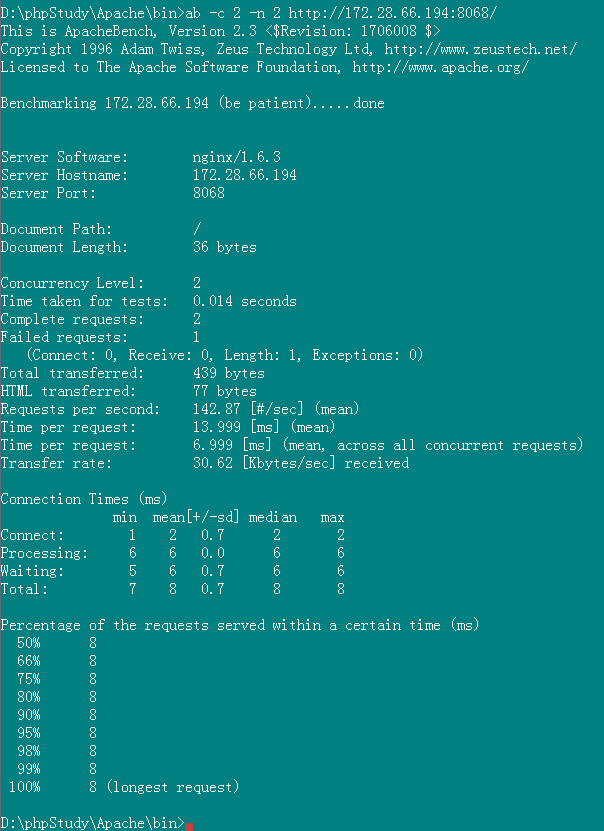

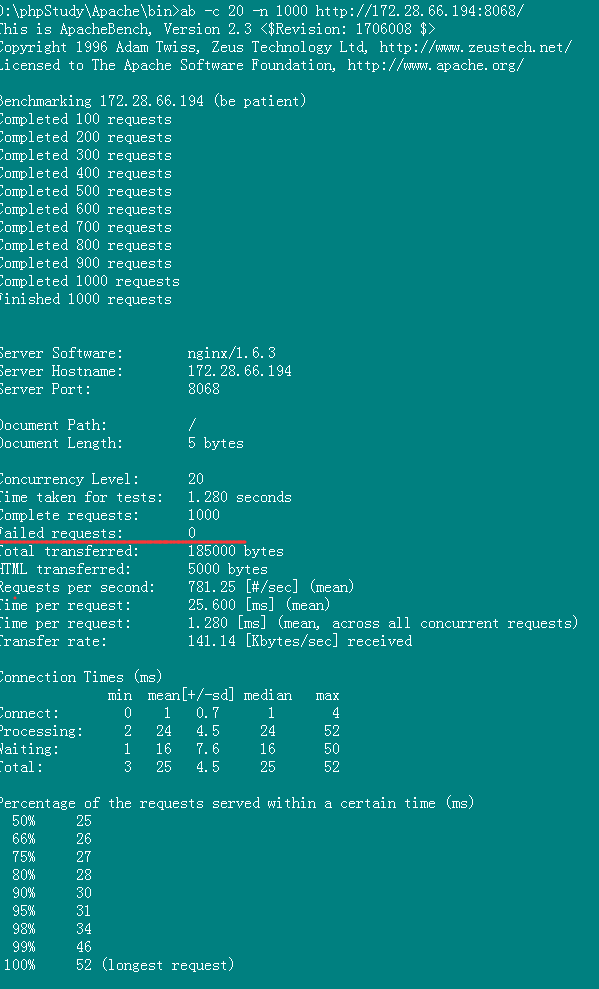

上面都已经配置完成后,使用apache ab 工具测试下:

ab工具测试

每秒钟处理781个请求 QPS

ab命令执行详细讲解:

[root@vic html]# ab -c 10 -n 100 http://172.28.66.194:8068/ This is ApacheBench, Version 2.3 <$Revision: 1706008 $> Copyright 1996 Adam Twiss, Zeus Technology Ltd, http://www.zeustech.net/ Licensed to The Apache Software Foundation, http://www.apache.org/ Benchmarking www.myvick.cn (be patient).....done Server Software: nginx/1.13.6 #测试服务器的名字 Server Hostname: 172.28.66.194 #请求的URL主机名 Server Port: 8068 #web服务器监听的端口 Document Path: / #请求的URL中的根绝对路径,通过该文件的后缀名,我们一般可以了解该请求的类型 Document Length: 5 bytes #HTTP响应数据的正文长度 Concurrency Level: 10 # 并发用户数,这是我们设置的参数之一 Time taken for tests: 0.668 seconds #所有这些请求被处理完成所花费的总时间 单位秒 Complete requests: 100 # 总请求数量,这是我们设置的参数之一 Failed requests: 0 # 表示失败的请求数量,这里的失败是指请求在连接服务器、发送数据等环节发生异常,以及无响应后超时的情况 Write errors: 0 Total transferred: 96200 bytes #所有请求的响应数据长度总和。包括每个HTTP响应数据的头信息和正文数据的长度 HTML transferred: 79900 bytes # 所有请求的响应数据中正文数据的总和,也就是减去了Total transferred中HTTP响应数据中的头信息的长度 Requests per second: 149.71 [#/sec] (mean) #吞吐率,计算公式:Complete requests/Time taken for tests 总请求数/处理完成这些请求数所花费的时间 Time per request: 66.797 [ms] (mean) # 用户平均请求等待时间,计算公式:Time token for tests/(Complete requests/Concurrency Level)。处理完成所有请求数所花费的时间/(总请求数/并发用户数) Time per request: 6.680 [ms] (mean, across all concurrent requests) #服务器平均请求等待时间,计算公式:Time taken for tests/Complete requests,正好是吞吐率的倒数。也可以这么统计:Time per request/Concurrency Level Transfer rate: 140.64 [Kbytes/sec] received #表示这些请求在单位时间内从服务器获取的数据长度,计算公式:Total trnasferred/ Time taken for tests,这个统计很好的说明服务器的处理能力达到极限时,其出口宽带的需求量。 Connection Times (ms) min mean[+/-sd] median max Connect: 1 2 0.7 2 5 Processing: 2 26 81.3 3 615 Waiting: 1 26 81.3 3 615 Total: 3 28 81.3 6 618 Percentage of the requests served within a certain time (ms) 50% 6 66% 6 75% 7 80% 7 90% 10 95% 209 98% 209 99% 618 100% 618 (longest request) #Percentage of requests served within a certain time(ms)这部分数据用于描述每个请求处理时间的分布情况,比如以上测试,80%的请求处理时间都不超过7ms,这个处理时间是指前面的Time per request,即对于单个用户而言,平均每个请求的处理时间

注:在ab测试中 出现 Faild Request 很高的情况下,可能是因为负载均衡返回的页面大小不一样。